Stöd gärna bloggen via Swish (Sverige), MobilePay (Finland) eller Wise.

Vetenskapsrådet har bett ett gäng pedagoger analysera om betyg vid 10-års ålder är bra eller dåligt. Det handlar om huruvida man ska ge feedback på lärandeprestation i form av siffror eller omdöme – att läraren med ord berättar vad de anser om elevens lärandeprestation – till elever i årskurs 4. Det här frågan spänner över politik, filosofi och vetenskap och berör

- det konceptuella, hur man definierar begreppen, liksom.

- det metodologiska – hur man analyserar och validerar begreppen och dess inbördes relationer.

Rapporten från Vetenskapsrådet – har utifrån ett pedagogiskt (utbildningskunskapligt) perspektiv reflekterat över frågor om hur skolan ska kunna samverka med vetenskap (systematisk och objektiv prövning).

Ett av avsnitten – Betygens geografi – forskning om betyg och summativa bedömningar i Sverige och internationellt – rör betyg. Ansvarig för den sammanställningen: Christian Lundahl, professor i pedagogik. Till sin hjälp har Lundahl haft Alli Klapp, Lektor i pedagogik, Göteborgs universitet, Larissa Mickwitz, fil lic och doktorand vid Södertörns högskola (numer vid SU), Magnus Hultén, Lektor i teknikens didaktik och docent i naturvetenskapernas didaktik, Linköpings universitet. Sammanställningen har utgått från 4 frågeställningar:

I den första delstudien studeras hur betyg ur ett elevperspektiv påverkar självbild, motivation och lärande.

den andra delstudien har forskning sammanställts om betyg ur ett lärarperspektiv

– hur och vad lärare betygsätter och hur betyg påverkar undervisning.

Delstudie tre handlar om betyg som

styrinstrument på olika nivåer i utbildningssystemet.

I delstudie fyra beskrivs betyg utifrån olika komparativa perspektiv.Författarna har dragit slutsatser om sifferbetygs påverkan (tänk orsak – verkan som i kausalitet) på skolprestation (kognitiv utveckling).

Redan här ringer varningsklockor eftersom pedagogernas ansats endast leder till hypoteser.

Enligt sydsvenskan har professor Lundahl dels avvisat argumentet att det finns en association mellan feedback i form av betyg och skolprestation (lärande/kognitiv utveckling) för barn som är tio år gamla, dels avvisat forskning som publicerats före år 2000. Istället torgförs idén att nämnda betyg har en negativ inverkan på barns självbild (självkänsla och self-efficacy är associerade begrepp) vilket i sin tur ska hämma motivationen att lära.

Det finns även inslag av ideologiskt ställningstagande i uttalanden om rapporten:

Forskarna i betygsprojektet påstår att de gått igenom 6 000 artiklar i utbildningsvetenskapliga och samhällsvetenskapliga databaser, noga studerat 500 av dem samt ett 40-tal avhandlingar. En del av litteraturen på Folkpartiets lista har forskargruppen också läst. Men inte rapporten från 1935.

– Oj, det känns helt irrelevant. Vi har inte tittat på någon forskning före 2000. Det här är ett forskningsområde som förändras något alldeles otroligt. Att hänvisa till forskningsresultat som är 80 år gamla, det är lite märkligt, säger Christian Lundahl.Länk till källan

Det blev förstås, som sig bör, en politisk debatt om detta. Jan Björklund, den enda politiker som från hjärtat talar varmt om skolan, verkar gilla betyg.

Även den politiska vänstern gav sig in i debatten genom vänster-orienterade Aftonbladets krönikor Karin Pettersson. Hen verkar ha kastat sig över tangentbordet i affekt (säger min expertis om emotionspsykologi). Istället för att fokusera på attitydobjektet (Balansteorin (Heider, 1958)) valde Pettersson en mer känslomässig ansats – polemik – personangrepp (flera invektiv används):

“Folkpartiet älskar att betygsätta och sortera barn. Det är grunden i deras skolpolitik som väljarna med kraft dömde ut i valet i höstas” (Pettersson, 2015.)I ytterligare en krönika med den braskande rubriken – Tioåringarna blir försökskaniner – skriver Pettersson:

“Tidigare betyg leder till tidigare sortering av barn. Det är en farlig utveckling i ett system där föräldrarnas utbildningsnivå spelar allt större roll och där skolan inte längre kompenserar för skillnader i klass och bakgrund.

I valet tackade väljarna kraftfullt nej till både Jan Björklunds parti och hans skolpolitik. Skolan var väljarnas viktigaste fråga och de ville ha förändring”.Bildvalet är intressant:

(Länk till källan).

Här undrar man över vilka premisser Pettersson utgått ifrån när hen påstår att väljarna kraftfullt tackade nej till Folkpartiet? (jag har frågat Pettersson om detta via mail den 19 december 2014. Hen valde att ignorera min fråga, dvs. stonewalling.

Läs mer om kvinnors relationsaggressivitet i Crick och Grotpeter (1995).

Det senaste riksdagsvalet vanns av den så kallade Alliansen som består av fyra parter: Centern, Folkpartiet, Kristdemokraterna och Moderaterna. Detta torde Pettersson, som ägnar sitt yrkesliv åt politiska spörsmål, känna till.

Genom att beakta symboliska representationer som siffror ser man att Moderaterna fick 23,33 % av rösterna, Centern 6,11 %, Folkpartiet 5,42 % och Kristdemokraterna 4,57 %. Genom att tillämpa aritmetik kan dessa procentsatser adderas vilket leder till en summa: 39,43 %.

Med samma räknelära blir summan av Socialdemokraternas (31,01 %) och Miljöpartiets (6,89 %) röster 37,90 % (Resultatet av 2014 års Riksdagsval).

Pettersson borde ha noterat att 39,43 > 37,90. Det konstiga tecknet i mitten betyder 'större än'. (I PISAs rapport om skolprestation noteras att svenska ungdomar blivit sämre på att hantera siffror. Undrar hur det är i vuxenvärlden?).

Resultatet, vare sig man gillar det eller inte, förklarar varför S+MP tvingas regera med Alliansens budget samt utifrån flera av de beslut som Alliansen fattat. Det finns andra knasigheter i Pettersson text.

“Istället för ideologisk debatt får vi en mesig kompromiss”.Mesig kompromiss!?

Kompromisser – är ett beslut som syftar till att genom förhandling tillfredsställa flera parter i en intressekonflikt, genom att balansera för– och nackdelar för de inblandade – är ju ett primärt verktyg för social kreativitet.

Observera att den åsiktsdivergens som råder mellan Björklund (liberal) och Pettersson (till vänster som det verkar) är en toppen-premiss för det ovan nämnda. Det är ju förmågan att samarbeta trots meningsskiljaktigheter som varit motorn i utvecklingen av det moderna samhället (från renässansen räknat). Det är viktigt att lära skolbarn, studenter och vuxna att kompromissa för att bli duktiga på att tillsammans lösa problem.

“En unikt enig remissopinion av myndigheter, lärosäten och lärare har sågat förslaget. Forskningen har dömt ut det och till sist har till och med Jan Björklunds allianskamrater börjat vackla.Åter igen är Pettersson ute och cyklar. Det är sant att Vetenskapsrådet (VR) låtit producera en rapport där ett avsnitt handlar om betyg. Ansvarig för det avsnittet var Christian Lundahl, professor i pedagogik. Några egentliga vetenskapliga slutsatser som avvisar idén om en association mellan 10-åringars lärandeprestation/kognitiva utveckling och feedback i form av sifferbetyg står dock inte att finna i VR:s rapport (Inga referenser bifogas heller).

Vetenskapsrådet gick nyligen igenom 6 000 artiklar och kunde inte hitta “en enda vetenskapligt publicerad artikel som förespråkar tidigt betygsättning.”

Ett annat perspektiv ges av Martin Ingvar, professor i integrativ medicin vid Karolinska Institutet:

“Det är alltså lika felaktigt att påstå att det finns otvetydiga vetenskapligt baserade slutsatser att betyg inte är bra i 4 klass (som artikelförfattarna skriver) som att det skulle vara bra (som utredningen inte skriver)”(Martin Ingvar om betyg på DN debatt).Karin Pettersson har tydligen läst Sydsvenskan och gör en så kallat rewrite*.

Stämmer uppgiften om referenserna?

Eftersom referenslistan saknades i VR:s rapport hörde jag av mig till VR:s generaldirektör Sven Stafström om detsamma. Svar kom snabbt, men från Professor Lundahl som skickade mig listan med de 291 artiklarna som använts som underlag för rapporten (dessa citeras i appendix).

Noterbart är att Lundahl i mail till mig uttryckte märkbar irritation över att jag avslöjat vilka referenser han använt. Lundahl, som promoverats till professor, borde känna till att det åligger honom att redovisa referenserna.

Jag ställer mig också frågande till påståendet att forskning daterad före år 2000 skulle vara irrelevant för denna fråga. Så argumenterar inga seriösa forskare.

Snarare är det så att majoriteten av forskningen om skolprestation dateras 1900 – någonting.

Hämmar betyg i årskurs 4 skolprestation, eller är det andra faktorer som spelar roll i den ekvationen?

Om detta vill jag resonera utifrån sakliga argument. Min utgångspunkt är följande:

- Marknadsföring, speciellt konsumentattityder, IHM, 1994.

-

Fil kand, Företagsekonomi, speciellt organisationers lärande. Kvalitativ ansats. Högskolan i Gävle, 2002.

- Fil mag, Företagsekonomi, organisationers lärande, kvantitativ ansats. Högskolan i Gävle, 2004.

- Fil kand, Experimentell emotionspsykologi/ psykofysiologi. Uppsala universitet, 2001.

- Fil mag, Social psykologi. Mälardalens högskolan, 2004.

- Fil Dr. Arbets- och organisationspsykologi, Lunds Universitet, 2012.

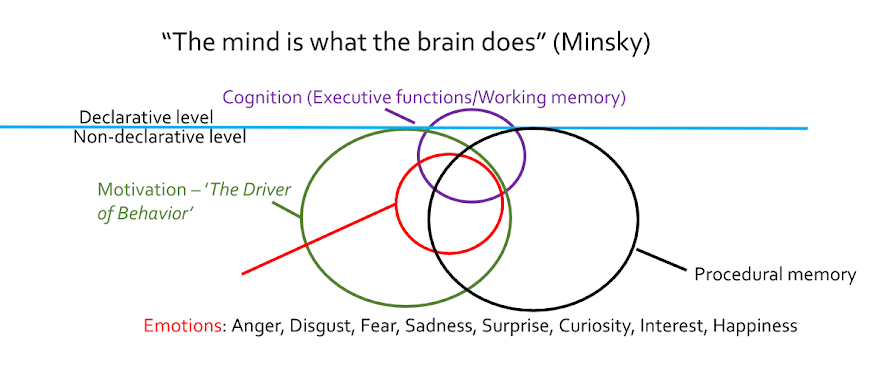

Det är viktigt att förstå begreppet motivation – “the driver of behavior” (ett av flera evolutionära PRIME; se Buck, R. (1985). Prime Theory. An Integrated View of Motivation and Emotion).

Lärande – kognitiv utveckling:

“nya beteenden kan förvärvas genom att observera och imitera andra.[1] Den slår fast att lärande är en kognitiv process som sker i ett socialt sammanhang och kan ske rent genom observation eller direkt undervisning, även i frånvaro av motorisk reproduktion eller direkt förstärkning (Bandura, 1971).

Närhelst hjärnan varit aktiv och aktiviteten gett någon form av bestående spår som längre fram kan påverka neuronala processer – då har vi ett fall av inlärning och minne”(Eriksson 2001, s. 125)Psykologisk forskning visar att grunden för barns inlärning (kognitiva utveckling) hänger samman med hemmiljön. Psykologen Diana Baumrind visade redan på 1960-talet hur uppfostringsstil predicerar kogntiv utveckling runt 10-års ålder (framgång i livet). Baumrind lyfter fram resonerande, diskussion och förhandling där föräldrarna låter 'bästa argumentet' vinna (Baumrind, 1966).

Hart och Risley (1995) följde i Baumrinds spår och visade, på temat Early childhood education, hur föräldrarnas samtalsstil under barnets första tre levnadsår predicerar skolprestation vid 9 års ålder. Barn till föräldrar som kommunicerar med en akademisk stil (resonerar) vinner otroliga 30 000 000 ordperceptioner jämfört med barn vars föräldrar har en tillrättavisande ton. Studien presenterades även i ett populärvetenskapligt perspektiv i New York Times så sent som 2013 – The Power of Talking to Your Baby:

“By the time a poor child is 1 year old, she has most likely already fallen behind middle-class children in her ability to talk, understand and learn. The gap between poor children and wealthier ones widens each year, and by high school it has become a chasm. American attempts to close this gap in schools have largely failed, and a consensus is starting to build that these attempts must start long before school — before preschool, perhaps even before birth”.Arden et al (2014) presenterade nyligen en studie som indikerar att 4 – åringars förmåga att uttrycka sig i bild (att genom uppmaning kunna rita en personliknande figur med 12 detaljer) predicerar deras skolprestation vid 12 års ålder. Studien tar avstamp i Florence Goodenoughs forskning (Draw-a-Person test) från, håll i hatten Lundahl, 1926! och hävdar en genetisk förklaringsmodell.

Speciellt papparelationer påverkar/förklarar barns emotionella och sociala anpassning som lägger grunden för kognitiv utveckling (Vieno et al. 2009, 2014; Österberg, 2004):

“En sammanställning av 28 undersökningar om pappa-frånvarons effekter på barns kognitiva förmåga (Shinn, 1978), indikerar att pappa-frånvaro som en funktion av skilsmässa är negativt relaterad till intellektuell kompetens hos barn; vilket även påvisats i tidigare studier (Blanchard & Biller, 1971; Crescimbeni, 1965; Ferri, 1976; Hetherington et al., 1978, 1982; Radin, 1976; Radin et al., 1994; Santrock, 1972; Sutton–Smith et al., 1978). Shinn (1978) menar att resultaten av sammanställningsstudien är konsistent med hypotesen att barns interaktion med föräldrarna formar en plattform för kognitiv utveckling, och att en minskning av denna interaktion hämmar den kognitiva utvecklingen” (Österberg, 2004, s. 2).Ergo. Skolprestation förklaras till stor del av det som sker i hemmet innan man börjar skolan eller av föräldrarelationer efter att man börjat skolan.

Som av händelse gjorde jag en egen sökning i forskningsdatabasen PsycINFO. Där valde jag avancerad sökning. Sedan skrev jag in tre sökord/begrepp: “Grades”, “10 year old Children” och “School performance or academic performance”. Begreppen kommer automatiskt upp när man börjar skriva dem. Det betyder i sin tur att det finns en del forskning om dessa tre begrepp och dess inbördes association. Resultat: 50 träffar.

Den äldsta publicerades 1928 och den nyaste 2014. Vetenskapsrådets utvärderare hade dock gjort en avgränsning som innebar att forskning som publicerats före 2000 exkluderats.

När jag gjorde detsamma återstod 35 artiklar (0,5 % av 6000; 12 % av 291). När jag lade till sökvillkoret “Self-image” som verkar vara ett centralt begrepp i Lundahls diskursiva ansats: då fick jag 0 träffar.

När jag tog bort ålder, dvs. behöll Grades, School Performance och Self-image som kriterium: då fick jag 20 träffar. När jag valde att ta med “School performance and academic performance” och 10 year old Children”, dvs. exkluderade grades och self-image: då fick jag 246 träffar. Observera att två kriterier är exkluderade. Ändå blir det 84 % av 291 respektive 4,1 % av påstådda 6000.

Slutsatserna blir:

- att Vetenskapsrådet genom utredaren professor Lundahl inte lyckats påvisa/avvisa effekter av betyg på skolprestation, (se även Martin Ingvar, DN).

- att Lundahl är ute på villovägar när han avvisar forskningsresultat daterade före år 2000.

- att Vetenskapsrådet/Lundahl gör ett klavertramp genom att inte redovisa referenserna till rapporten (och att bli irriterade när dessa efterfrågas).

- att det snarare är andra faktorer än betyg som är avgörande (huvudeffekt) för skolprestation/kognitiv utveckling (se Baumrind, 1966; Hart & Risley, 1995, Vieno et al. 2009, 2014; Österberg, 2004).

Please support the blog via Swish (Sweden), MobilePay (Finland) or Wise.

Mer om min expertis:

Executive coaching for CEOs/managers and workshops to facilitate Organizational Performance, Learning, and Creativity for Problem Solving | Lectures: Nutrition for physical and mental health | Course/lecture: children's emotional and social adjustment and cognitive development |Language training - Swedish | Academy Competency | CV | Teaching skills and experience | Summary of research project | Instagram | Linkedin | YouTube-channel | TikTok | Twitter

Appendix – Citat av Christian Lundahls mail (150129): “Referenslista” som innehåller de 291 referenser som var underlag till VR:s rapport. (Observera att det i vetenskapliga sammanhang självklart att man publicerar referenser. Varför valde VR/Lundahl att inte göra det?)

Referenslista

-

Abu-Hamour, B., & Mattar, J. (2013). The applicability of

curriculum-based-measurement in math computation in Jordan. International

Journal of Special Education, 28(1), 111-119.

- Allal,

L. (2013). Teachers’ professional judgement in assessment: a cognitive act and

a socially situated practice. Assessment

in Education: Principles, Policy & Practice, 20 (1), 20-34.

- Alley,

V. M. (2002). Midterm grade reports: Are they effective? Research and

Teaching in Developmental Education, 19(1), 14-24.

- Amrein,

A. L., & Berliner, D. C. (2002). High-stakes testing & student

learning. Education policy analysis

archives, 10(18), 1-74.

- Amrein,

A. L., & Berliner, D. C. (2003). The effects of high-stakes testing on

student motivation and learning. Educational Leadership, 60(5),

32-38.

- Andersson, H. (1991). Relativa betyg: några

empiriska studier och en teoretisk genomgång i ett historiskt perspektiv (Doktorsavhandling,

Umeå universitet).

- Annerstedt,

C., & Larsson, S. (2010). “I Have My Own Picture of What the Demands

Are...”: Grading in Swedish PEH - Problems of Validity, Comparability and

Fairness. European Physical Education Review, 16 (2),

97-115.

- Artes,

J., & Rahona, M. (2013). Experimental evidence on the effect of grading

incentives on student learning in Spain. Journal of Economic Education, 44(1),

32-46.

-

Au, W. (2007). High-Stakes Testing and

Curricular Control: A Qualitative Metasynthesis. Educational Researcher, 36(5),

258-267.

-

Au, W. (2011). Teaching under the new Taylorism: high stakes testing and the standardization of the 21st century curriculum. Journal of Curriculum Studies, 43 (1), 25-45.

-

Azmat,

G., & Iriberri, N. (2010). The importance of relative performance feedback

information: Evidence from a natural experiment using high school students. Journal of Public Economics, 94 (7-8), 435-452.

- Bagley,

S. S. (2008). High school students' perceptions of narrative evaluations as

summative assessment. American Secondary Education, 36(3), 15-32.

-

Baird, J.-A., Greatorex, J., & Bell, J. F. 2010. What makes marking reliable?

Experiments with UK examinations. Assessment in Education: Principles, Policy

& Practice, 11 (3), 331-348.

-

Baker,

E. L., & O'Neil Jr, H. F. (1994). Performance Assessment and Equity: a view

from the USA. Assessment in Education:

Principles, Policy & Practice, 1 (1),

11-26.

- Bandiera, O., Barankay, I., & Rasul, I. (2009). Team incentives: evidence from a

field experiment. Mimeo.

- Bandiera,

O., Larcinese, V., & Rasul, I. (2008). Blissful ignorance? Evidence from a natural

experiment on the effect on individual feedback on performance. Mimeo.

- Bautier, É., Crinon, J., Rayou, P., & Rochex, J. Y. (2006).

Performances en littéracie, modes de faire et univers mobilisés par les élèves:

analyses secondaires de l'enquête PISA 2000. Revue française de pédagogie,

157, 85-101.

- Becker,

W. E., & Rosen, S. (1992). The learning effect on assessment and evaluation

in High School. Economics of Education

Review, 11(2), 107-118.

- Benveniste,

L. (2002). The Political Structuration of Assessment: Negotiating State Power

and Legitimacy.Comparative Education Review, 46(1), 89-118.

-

Bergman, L. (2007). Gymnasieskolans svenskämnen. Malmö: Malmö högskola.

- Betts,

J. R., & Grogger, J. (2003). The impact of grading standards on student

achievement, educational attainment, and entry-level earnings (hög relevans). Economics

of Education Review,22 (4),

343-52.

- Biberman-Shalev, L., Sabbagh, C., Resh, N., & Kramarski, B. (2011).

Grading styles and disciplinary expertise: The mediating role of the teacher’s

perception of the subject matter. Teaching and Teacher Education, 27 (5),

831-840.

- Bies-Hernandez,

N. (2012). The effects of framing grades on student learning and preferences. Teaching

of Psychology, 39(3), 176-180.

- Billing,

D. (2004). International Comparisons and Trends in External Quality Assurance

of Higher Education: Commonality or Diversity? Higher Education, 47 (1),

113-137.

-

Black, P., Harrison, C., Hodgen J., Marshall B., & Serret N. (2010). Validity in

teachers’ summative assessments. Assessment

in Education: Principles, Policy & Practice, 17 (2), 215-232.

-

Black, P., & Wiliam, D. (2005). Lessons from around the world: how policies, politics

and cultures constrain and afford assessment practices. The Curriculum Journal, (2), 249-261.

- Black,

P., & Wiliam, D. (1998). Assessment and classroom learning. Assessment in Education, 5 (1), 7-74.

- Black,

P., Harrison, C., Hodgen, J., Marshall, B., & Serret, N. (2011). Can

teachers' summative assessments produce dependable results and also enhance

classroom learning? Assessment in Education: Principles, Policy

Practice, 18(4), 451-469.

- Black,

P., & Wiliam, D. (2011). The reliability of assessments. In J. Gardner (Ed.),

Assessment and Learning (pp. 243–263). Los Angeles and London: Sage

Publications.

- Blok, H. Otter, M. E., & Roeleveld, J. (2002). Coping with Conflicting Demands:

Student Assessment in Dutch Primary Schools. Studies in Educational

Evaluation, 28 (2),

177-188.

- Bloom,

D. (2009). Collaborative test taking: Benefits for learning and retention.

College Teaching, 57(4), 216-220.

- Boehnke, K. (2005). Value orientations in relation to mathematical

self-esteem: An exploratory study of their role in mathematical achievement

among German, Israeli, and Canadian 14-year-olds.European journal of

psychology of education, 20 (3), 227-241.

- Bonesronning, H. (2004). Do the teachers' grading practices affect student achievement?

Education Economics, 12(2), 151-167.

- Bonnet, G. (1997). Country Profile from France. Assessment in Education: Principles,

Policy & Practice, 4 (2), 295–306.

-

Bowers, A.J. (2010a). Analyzing the Longitudinal K-12

Grading Histories of Entire Cohorts of Students: Grades, Data Driven Decision

Making, Dropping Out and Hierarchical Cluster Analysis. Practical

Assessment, Research Evaluation (PARE), 15 (7), 1-18.

- Bowers, A. J. (2010b). Grades and Graduation: A Longitudinal Risk Perspective to

Identify Student Dropouts. Journal of

Educational Research, 103(3), 191-207.

- Bowers, A.J., & Sprott, R. (2012). Examining the Multiple Trajectories Associated

with Dropping Out of High School: A Growth Mixture Model Analysis. The

Journal of Educational Research, 105(3), 176-195.

- Bowers, A.J., Sprott, R., & Taff, S.A. (2013). Do we

Know Who Will Dropout? A Review of the Predictors of Dropping out of High

School: Precision, Sensitivity and Specificity. The High School Journal, 96(2),

77-100.

- Braun, H. (2004). Reconsidering the Impact of High-stakes Testing. Education Policy Analysis Archives, 12(1), 1-43.

- Brennan, R. T., Kim, J., Wenz-Gross, M., & Siperstein, G. N. (2001).

The relative equitability of high-stakes testing versus teacher-assigned

grades: An analysis of the Massachusetts Comprehensive Assessment System

(MCAS). Harvard educational review,

71 (2), 173-217.

- Brilleslyper,

M., Ghrist, M., Holcomb, T., Schaubroeck, B., Warner, B., & Williams, S.

(2012). What's the point? The benefits of grading without points. Primus, 22(5),

411-427.

- Brookhart,

S. M. (2011). Starting the Conversation about Grading.Educational

Leadership, 69(3), 10-14.

- Brookhart, S. M. (2013). Educational Assessment Knowledge and Skills for Teachers. Educational Measurement: Issues and Practice,

30(1), 3-12.

- Brookhart, S. M. (2013). The use of teacher judgement for summative assessment in the USA.

Assessment in Education: Principles,

Policy & Practice, 20(1), 69-90.

-

Butler,

R. (1988). Enhancing and undermining intrinsic motivation: The effects of

task-involving and ego-involving evaluation on interest and performance. British Journal of Educational Psychology, 58 (1), 1-14.

-

Böhlmark, A., & Holmlund, H. (2011). 20 år med förändringar i skolan: Vad har

hänt med likvärdigheten? Stockholm:

SNS förlag.

-

Cameron, J. (2001). Negative

effects of reward on intrinsic motivation—a limited phenomenon: Comment on Deci, Koestner, and Ryan (2001). Review of Educational Research, 71(1), 29-42.

-

Cameron, J., Banko, M., & Pierce, D. (2001). Pervasive negative effects of rewards

on intrinsic motivation: the myth continues. The Behavior Analyst, 24(1), 1-44.

- Carifio,

J., & Carey, T. (2010). Do minimum grading practices lower academic

standards and produce social promotions? Educational Horizons, 88(4),

219-230.

- Carifio,

J., & Carey, T. (2013). The arguments and data in favor of minimum grading.

Mid-Western Educational Researcher, 25(4), 19-30.

- Carrillo-de-la-Pena,

M. T., & Perez, J. (2012). Continuous assessment improved academic

achievement and satisfaction of psychology students in Spain. Teaching of

Psychology, 39(1), 45-47.

- Chevins,

P. F. (2005). Lectures replaced by prescribed reading with frequent assessment:

Enhanced student performance in animal physiology. Bioscience Education

e-Journal, 5.

- Chilisa,

B. (2000). Towards Equity in Assessment: Crafting gender-fair assessment. Assessment in Education: Principles, Policy

& Practice, 7(1), 61-81.

- Christophersen,

K-A., Elstad, E., & Turmo, A. (2012). Antecedents of Teachers Fostering

Effort within Two Different Management Regimes: An Assessment-Based

Accountability Regime and Regime without External Pressure on Results. International Journal of Education Policy

& Leadership, 7 (6).

- Cilliers,

F. J., Schuwirth, L. W. T., Herman, N., Adendorff, H. J., & van der Vleuten, C. P. (2012). A model

of the pre-assessment learning effects of summative assessment in medical

education. Advances in Health Sciences Education, 17(1), 39-53.

- Cilliers,

F. J., Schuwirth, L. W., Adendorff, H. J., Herman, N., & van der Vleuten, C. P. (2010). The

mechanism of impact of summative assessment on medical students' learning.

Advances in Health Sciences Education, 15(5), 695-715.

- Cizek,

G. J. (2001). More unintended consequences of high-stakes testing.

Educational Measurement: Issues and Practice, 20(4), 19-27.

- Clark, D., & See, E. (2011). The impact of tougher education standards: Evidence

from Florida.

Economics of Education Review, 30(6), 1123-1135. - Cliffordson, C. (2004). Betygsinflation i de

målrelaterade gymnasiebetygen. Pedagogisk

forskning i Sverige, 9 (1), 1-14.

- Cliffordson,

C. (2008). Differential prediction of study success across academic programs in

the Swedish context: The validity of grades and tests as selection instruments

for higher education. Educational

Assessment, 13 (1), 56-75.

- Clymer, J. B., & Wiliam, D. (2007). Improving the way we grade science.

Educational Leadership, 64(4), 36-42.

- Congon, P. J. & McQueen, J. (2000). The Stability of Rater Severity in Large-Scale

Assessment Programs. Journal of Educational Measurement, 37(2), 163-178.

-

Coniam, D. (2009). A comparison of onscreen and paper-based marking in

the Hong Kong public examination system. Educational Research and Evaluation,

15 (3), 243-263.

-

Cooksey, R. W. Freebody P., & Wyatt-Smith, C. (2007). Assessment as Judgment-in-Context:

Analysing how teachers evaluate students' writing, Educational Research and Evaluation: An International Journal on Theory and Practice, 13(5), 401-434.

- Covington, M. V. (2000). Goal theory, motivation, and school achievement: An integrative

review. Annual Review of Psychology, 51, 171-200.

-

Cox, K. B. (2011). Putting Classroom Grading on the Table: A Reform in Progress American

Secondary Education,240 (1),

67-87.

- Crooks, T. (1988). The impact of classroom evaluation practices on students. Review of Educational Research, 58 (4), 438-481.

- Cumming, J. J. (2008). Legal and educational perspectives of equity in assessment. Assessment in Education: Principles, Policy & Practice, 15 (2), 123-135.

- Dahl, B, Lien, E., & Lindberg-Sand, Å. (2009). Conformity or confusion? Changing

higher education grading scales as a part of the Bologna Process: the cases of

Denmark, Norway and Sweden. Learning and

Teaching: The International Journal of Higher Education in the Social Sciences, 2 (1), 39-79.

-

Dahlgren, L. O., Fejes, A., Abrandt-Dahlgren, M., & Trowald, N. (2009). Grading systems, features of assessment and students' approaches to learning. Teaching in Higher Education, 14 (2), 185-194.

- Danielewicz, J., & Elbow, P. (2009). A unilateral grading contract

to improve learning and teaching. College Composition and Communication, 61 (2),

244-268.

- Daugherty, R. (2008). Reviewing national curriculum assessment in Wales: how can evidence

inform the development of policy? Cambridge

Journal of Education, 38 (1), 73-87.

- De Lisle, J., Smith, P., Keller, C., & Jules, V. (2012). Differential outcomes

in high-stakes eleven plus testing: The role of gender, geography, and

assessment design in Trinidad and Tobago. Assessment in Education:

Principles, Policy & Practice, 19 (1), 45-64.

-

De Luca, C. (1994). The impact of examination systems on curriculum development: an international study.

Paris: UNESCO.

-

Deci, E. L., & Ryan, R. M. (1985). Intrinsic

motivation and self-determination in human behaviour. New York: Plenum.

- Deci, E. L., Koestner, R., & Ryan, R. M. (1999). A meta-analytic review of

experiments examining the effects of extrinsic rewards on intrinsic motivation.

Psychological bulletin, 125 (6), 627-668.

-

Deci, E. L., Koestner, R., & Ryan, R. M. (2001). Extrinsic rewards and intrinsic motivation in

education: Reconsidered once again. Review of Educational Research, 71 (1), 1-27.

- Dee, T. S. & Jacob, B. (2011). The impact of no Child Left Behind on student

achievement. Journal of Policy Analysis and Management, 30(3), 418-446.

-

DiBattista, D., Gosse, L., Sinnige-Egger, J., Candale, B., & Sargeson, K. (2009). Grading

scheme, test difficulty, and the immediate feedback assessment technique.Journal of Experimental Education, 77(4), 311-336.

-

Dlaska, A., & Krekeler, C. (2013). Does grading undermine feedback? The influence

of grades on the effectiveness of corrective feedback on L2 writing. The Language Learning Journal. DOI:

10.1080/09571736.2013.848226.

- Dobbins, M., & Martens, K. (2012). Towards an Education Approach a la

“Finlandaise”? French Education Policy after PISA. Journal of Education Policy, 27 (1), 23-43.

-

Docan, T. N. (2006). Positive and negative incentives in the classroom: An analysis of

grading systems and student motivation. Journal of Scholarship of Teaching

and Learning, 6(2), 21-40.

-

Dolton, P., & Marcenaro-Gutierrez, O. D. (2011). If you pay peanuts do you get

monkeys? A cross font-family country analysis of teacher pay and pupil performance. Economic Policy, 26(65), 5-55.

-

Dowdy, E., Kamphaus, R. W. (2007). A Comparison of Classification

Methods for Use in Predicting School-Based Outcomes. The California School Psychologist, 12 (1), 121-132.

-

Dragemark Oscarson, A. (2008). Self-Assessment of Writing in Learning English as a Foreign Language. A Study at the Upper Secondary School Level (Doktorsavhandling, Göteborgs universitet).

-

Ds 2008:13. En ny betygsskala. Stockholm: Utbildningsdepartementet.

-

Duncan R. C., & Noonan, B. (2007). Factors Affecting Teachers’ Grading and

Assessment Practices. Alberta Journal of Educational Research, 53 (1), 1-21.

-

Duckworth, A. L., & Seligman, E. P. (2005). Self-Discipline outdoes IQ in predicting

academic performance of adolescents. Psychological Science, 16 (12), 939-944.

-

Durlak, J. A. (2009). How to select, calculate, and interpret effect sizes. Journal of Pediatric Psychology, 34(5), 917-928.

-

Dweck, C. S. (1992). The study of goals in psychology. Psychological Science, 3 (3), 165-167.

-

Ecclestone, K. (2004). Learning in a comfort zone: cultural and social capital inside an

outcome based assessment regime. Assessment in Education: Principles, Policy & Practice, 11 (1), 29-47.

-

Elliott, A. J., Shell, M. M., Henry, K. B., & Maier, M. A. (2005). Achievement

goals, performance contingencies, and performance attainment: An experimental

test. Journal of Educational Psychology, 97(4), 630-640.

-

Emmett, J. (2013). Using extrinsic motivation to influence student attitude and

behavior toward state assessments at an urban high school. NASSP

Bulletin, 97(3), 197-217.

-

Englund, T., Forsberg, E., & Sundberg, D. (red.)

(2012). Vad räknas som kunskap?: läroplansteoretiska utsikter och inblickar i lärarutbildning och skola. Stockholm: Liber.

-

Eurydice (2014a). About Eurydice. Downloaded on December 20th 2014 from:

-

Eurydice (2014b). Compulsory Education in Europe 2014/2015, Facts and Figures, November

2014. Downloaded on December 20th 2014 from:

-

Eurydice (2014c). The Structure of the European Education Systems 2014/2015, Schematic

Diagrams, November 2014. Downloaded on December 20th 2014 from:

-

Feniger, Y., Livneh, I., & Yogev, A. (2012). Globalisation and the politics of

international tests: the case of Israel. Comparative

Education, 48 (3), 323-335.

-

Fernandes, D. (2009). Educational assessment in Portugal. Assessment in Education: Principles,

Policy & Practice, 16 (2), 227-247.

-

Forsberg, E. (2008). Framtidsvägen – en huvudled eller en skiljeväg? Utbildning & Demokrati, 17 (1),

75-98.

-

Forsberg, E., & Lundahl, C. (2006). Kunskapsbedömningar som styrmedia. Utbildning & Demokrati, 15 (3), 7-29.

-

Figlio, D. N., & Lucas, M. E. (2004). Do high grading standards affect student

performance? Journal of Public Economics, 88(9-10), 1815-1834.

-

Friedler, S. A.,Tan, Y. L., Peer, N. J., & Shneiderman, B. (2008). Enabling Teachers

to Explore Grade Patterns to Identify Individual Needs and Promote Fairer

Student. Assessment Computers & Education, 51(4), 1467-1485.

-

Frydenberg, E. (2008). Adolescent coping: Advances in

theory, research and practice. London, New York, NY: Routledge &

Francis Group.

-

Gewirtz, S. (1998). Conceptualizing social justice in education: mapping the territory. Journal of Education Policy, 13 (4), 469-484.

-

Gijbels, D., Dochy, F., Van den Bossche, P., & Segers, M. (2005).

Effects of problem-based learning: A meta-analysis from the angle of

assessment. Review of educational research, 75 (1), 27-61.

-

Gipps, C. (1995). What Do We Mean by Equity in Relation to Assessment? Assessment in Education: Principles, Policy

& Practice, 2 (3), 271-281.

-

Gipps, C. (1999). Sociocultural aspects of assessment. Review of Research in Education, 24 (1), 355-392.

-

Grmek, M. I., & Krecic, M. J. (2004). Impact of external examinations

(Matura) on school lessons.Educational Studies,30 (3), 319-330.

-

Gustafson, N. (2010). Lärare i en ny tid om grundskollärares förhandlingar av professionella

identiteter (Doktorsavhandling, Malmö högskola).

-

Gustafsson, J. E. (2006). Barns utbildningssituation. Bidrag till ett kommunalt barnindex.

Stockholm: Rädda Barnen.

-

Gustafsson, J. E. (2013). Förändringar i kunskapsbedömningar på individ- och systemnivå i den svenska skolan under 25 år. I I. Wernersson & I. Gerrbo (red.), Differentieringens

janusansikte: En antologi från Institutionen för pedagogik och specialpedagogik

vid Göteborgs universitet (s. 45-75). Göteborg: Göteborgs universitet.

- Gustafsson, J. E., & Erickson, G. (2013). To Trust or Not to Trust?–Teacher Marking

versus External Marking of National Tests. Educational Assessment, Evaluation and

Accountability,, 25 (1), 69-87.

-

Gustafsson, J. E., Cliffordson, C., & Erickson, G. (2014). Likvärdig

kunskapsbedömning i och av den svenska skolan: Problem och möjligheter. Stockholm: SNS förlag.

-

Hacking, I. (1995). The Looping Effects of Human Kinds. I: D. Sperber, D.

Premack, & A. J. Premack (red.). Causal Cognition: A Multi-Disciplinary Approach. Oxford: Clarendon Press.

-

Hall, K., & Harding, A. (2002). Level descriptions and teacher assessment in

England: towards a community of assessment practice. Educational Research, 44 (1),

1-16.

-

Hancock, D. R. (2007). Effects of performance assessment on the achievement and

motivation of graduate students. Active Learning in Higher Education, 8(3),

219-231.

-

Hanna, R. N., Linden, L. L. (2012). Discrimination in Grading. American Economic Journal:

Economic Policy, 4 (4), 146-168.

-

Harlen, W., & Deakin Crick, R. (2002). A systematic review of the impact of

summative assessment and tests on students´ motivation for learning

(EPPI-Centre Review, version 1.1*). In: Research

evidence in educational library. Issue 1. London: EPPI-Centre, Social

Science Research Unit, Institute of Education.

-

Harlen, W. (2004). A systematic review of the evidence of reliability and validity of

assessment by teachers used for summative purposes. In: Research Evidence in

Education Library. London: EPPI-Centre, Social Science Research Unit,

Institute of Education, University of London.

-

Harlen, W. (2005). Teachers' summative practices and assessment for learning – tensions

and synergies. Curriculum Journal, 16 (2), 207-223.

-

Hattie, J. A. C. (2009). Visible learning: A

synthesis of 800+ meta-analyses on achievement. London: Routledge.

-

Hattie, J., & Timperley, H. (2007). The power of feedback. Review of Educational

Research, 77(1), 81-112.

-

Heilig, J. V. (2011). Understanding the interaction between high-stakes graduation

tests and English learners. Teachers College Record,113 (12), 2633-2669.

-

Hendrickson, K. A. (2012). Assessment in Finland: A Scholarly Reflection on One Country's Use of Formative, Summative, and Evaluative Practices. Mid-Western Educational Researcher,25 (1-2), 33-43.

-

Hobfoll, S. E. (1989). Conservation of resources: A new attempt at conceptualizing

stress. American Psychologist, 44(3), 513-524.

-

Hobfoll, S. E. (2001). The influence of culture, community, and the nested-self in

stress process: Advancing conservation of resources theory. Applied Psychology, 50 (3), 337-421.

-

Hopmann, S. T. (2003). On the evaluation of curriculum reforms. Journal of Curriculum Studies, 35(4), 459-478.

-

Hopmann, S. T. (2008). No child, no school, no state left behind: schooling in the age

of accountability. Journal of Curriculum Studies, 40 (4), 417-456.

-

Hopmann, T. S. (2013). The end of schooling as we know it? Journal of Curriculum Studies, 45 (1),

1-3.

-

Hout, M., & Elliot S. W. (2011). Incentives and test-based accountability in education. Washington:

The National Academies Press.

-

Hultqvist, E. (2011). Om lärarnas förändrade yrkesvillkor. Pedagogisk Forskning i

Sverige, 16(3), 202-213.

-

Hurtig, M. (2007). “Jag vågar visa att jag kan”. Om meningsskapande med digitala portföljer (Doktorsavhandling, Luleå tekniska universitet).

-

Isaacs, T. (2010). Educational assessment in England. Assessment in Education: Principles, Policy & Practice, 17 (3), 315-334.

-

Jacob, B. A. (2005). Accountability, incentives and behavior: the impact of

high-stakes testing in the Chicago Public Schools. Journal of Public Economics, 89 (5-6), 761-796.

-

Jansson, T. (2011). Vad kommer på provet? Gymnasielärares provpraxis i samhällskunskap(Licentiatavhandling, Karlstad universitet).

-

Johnson, M. (2007). Does the anticipation of a merit grade motivate vocational

test-takers? Research in Post-Compulsory Education, 12(2), 159-179.

-

Joughin, G. (2010). The hidden curriculum revisited: A critical review of research into

the influence of summative assessment on learning. Assessment &Evaluation in Higher Education, 35 (3), 335-345.

-

Karlsson, A. (2011). Samhällsguide, individualist och moderator: samhällskunskapslärares

professionella förhållningssätt i betygsättningsrelaterat arbete (Licentiatavhandling,

Karlstad universitet).

-

Kennedy, K. J., Chan, J. K. S., Fok, P. K., & Yu, W. M. (2008). Forms of assessment

and their potential for enhancing learning: Conceptual and cultural issues.

Educational Research for Policy and Practice, 7(3), 197-207.

-

Klapp Lekholm, A. (2011). Effects of School Characteristics on Grades in Compulsory

School. Scandinavian Journal of Educational Research. 55(6), 587-608.

-

Klapp Lekholm, A., & Cliffordson, C. (2008). Discrepancies between school grades

and test scores at individual and school level: effects of gender and family

background. Educational Research and Evaluation, 14 (2), 181-199.

-

Klapp Lekholm, A. (2010). Vad mäter betygen. I C. Lundahl & M. Folke-Fichtelius (red.), Bedömning i och av skolan – praktik, principer, politik. Lund:

Studentlitteratur.

-

Klapp Lekholm , A., & Cliffordson, C. (2008). Discrepancies between school grades and test

scores at individual and school level: effects of gender and family background.

Educational Research and Evaluation, 14 (2), 181-199.

-

Klapp, A. (2014). Does grading affect educational attainment? A longitudinal study. Assessment in Education: Principles, Policy and Practice, DOI: 10.1080/0969594X.2014.988121.

-

Klapp, A., Cliffordson, C., & Gustafsson, J-E. (2014). The effect of being graded

on later achievement: evidence from 13-year olds in Swedish compulsory school. Eductional Psychology: An international Journal of Experimental Educational Psychology. DOI:

10.1080/01443410.2014.933176.

-

Klein, J. (2002). The failure of a decision support system: inconsistency in test

grading by teachers. Teaching and Teacher Education, 18 (8), 1023-1033.

-

Klenowski, V., & Wyatt-Smith, C. (2012). The impact of high stakes testing: the

Australian story. Assessment in Education: Principles, Policy & Practice, 19 (1), 65-79.

-

Kluger, A. N., & DeNisi, A. (1996). The effects of feedback interventions on

performance: A historical review, a meta-analysis, and a preliminary feedback

intervention theory. Psychological

Bulletin, 119 (2), 254-284.

-

Korp, H., (2006). Lika chanser i gymnasiet? En

studie om betyg, nationella prov och social reproduktion (Doktorsavhandling,

Malmö högskola).

-

Krasne, S., Wimmers, P. F., Relan, A., & Drake, T. A. (2006). Differential effects

of two types of formative assessment in predicting performance of first-year

medical students. Advances in Health Sciences Education, 11 (2), 155-171.

-

Kroksmark, T. (2002). En tankes fall i praktiken – då den målrationella styrningen möter skolan. I: Att bedöma eller döma: tio artiklar om bedömning och betygssättning. Stockholm: Skolverket.

-

Kurth, J., Gross, M., Lovinger, S., & Catalano, T. (2012). Grading Students with Significant Disabilities in Inclusive Settings: Teacher Perspectives. Journal of the International Association of Special Education, 13 (1), 41-57.

-

Lauder, H., Kounali, D., Robinson, T., & Goldstein, H. (2010). Pupil

composition and accountability: An analysis in English primary schools. International

Journal of Educational Research, 49 (2), 49-68.

-

Lee, J. (2008). Is test-driven external accountability effective? Synthesizing the

evidence from cross-state causal-comparative and correlational studies.Review of Educational Research, 78(3), 608-644.

-

Lindberg, V. (2002). Införandet av godkändgränsen - konsekvenser för lärare och elever. I: Att

bedöma eller döma: tio artiklar om bedömning och betygssättning. Stockholm:

Skolverket.

-

Lindberg, V. (2005). Svensk forskning om bedömning och betyg 1990–2005. Studies in Educational Policy and Educational Philosophy. E-tidskrift 2005:1.

-

Lindberg, V., & Forsberg, E. (2010). Svensk forskning om bedömning: en kartläggningn. Stockholm: Vetenskapsrådet.

-

Lindberg, V. & Löfgren R. (2011). Vad krävs för godkänt i kemi? I: Eriksson, I. (red.). Kemiundervisning,

text och textbruk i finlandssvenska och svenska skolor: en komparativ tvärvetenskaplig

studie. Stockholm: Stockholms universitets förlag.

-

Lindström, L., Lindberg V., & Pettersson, A. (red.) (2011). Pedagogisk bedömning: att

dokumentera, bedöma och utveckla kunskap. Stockholm: Stockholms

universitets förlag.

-

Lucas, M. E., & Figlio, D. N. (2004). The gentleman's “A”: New

evidence on the effects of grade inflation.Education Next. 4 (2),

60-66.

-

Lundahl, C. & Folke-Fichtelius, M. (red.) (2010). Bedömning i och av skolan – praktik,

principer, politik. Lund: Studentlitteratur.

-

Lundahl, C. (2006): Viljan att veta vad andra vet. Kunskapsbedömning i tidigmodern, modern

och senmodern skola (Doktorsavhandling, Uppsala universitet).

- Lundahl, C. (2009). Varför nationella prov? Framväxt, dilemman, möjligheter. Lund:

Studentlitteratur.

-

Lundahl, C. (2010). Nationella prov – ett redskap med tvetydiga syften. I C. Lundahl & M. Folke-Fichtelius (red.), Bedömning i och av skolan – praktik,

principer, politik. Lund: Studentlitteratur.

-

Lundahl, C., Román, H., & Riis, U. (2010). Tidigt ute med sena betyg – sent ute med tidiga! Svensk betygspolitik i ljuset av internationell betygsforskning och betygsättningen i Europa. Pedagogisk forskning i Uppsala nr 157. Uppsala: Uppsala universitet, Pedagogiska institutionen.

-

Lundahl, C. (2014). Kunskap in/om pedagogik – Produktion, visualisering och effekter av skolresultat. Utbildning & Demokrati, 23 (3), 7-31.

-

Lundahl, C., & Tveit, S. (2014). Att legitimera nationella prov i Sverige och Norge – en fråga om profession och tradition. Pedagogisk forskning i Sverige, 19 (4-5), 297-323.

-

Marchant, G. J., Paulson, S. E., & Shunk, A. (2006). Relationships between high-stakes testing policies and student achievement after controlling for demographic factors in aggregated data. Education Policy Analysis Archives, 14 (30), 1-34.

-

Marsh, H. W., Trautwein, U., Lüdtke, O., Köller, O., & Baumert, J. (2005). Academic self, concept, interest,

grades, and standardized test scores: Reciprocal effects models of causal ordering. Child development, 76(2), 397-416.

-

Martinez, J.F., Stacher, B., & Borko, H. (2009). Classroom Assessment Practices,

Teacher Judgments, and Student Achievement in Mathematics: Evidence from the

ECLS. Educational Assessment, 4 (2), 78-102.

-

Martinez, J. F. (2010). Rating Performance Assessments of Students with Disabilities: A Study of Reliability and Bias. Journal of Psychoeducational Assessment, 28 (6), 536-550.

-

Millan, J. H, Myran, S., & Workman, D. (2002). Elementary teachers'

classroom assessment and grading practices. The Journal of Educational Research, 95 (4), 203-213.

-

Mcclure, J. E., & Spector, L. C. (2005). Plus/Minus grading and motivation: An

empirical study of student choice and performance. Assessment and Evaluation

in Higher Education, 30(6), 571-579.

-

McDonnell, L. M. (1994). Assessment Policy as Persuasion and Regulation. American Journal of Education, 102 (4), 394-420.

-

McMillan, J. H. (2001). Secondary Teachers' Classroom Assessment and Grading Practices. Educational Measurement: Issues and Practice, 20-32.

-

Meadmore, D. (1995). Linking Goals of Governmentality with Policies of Assessment. Assessment in Education: Principles, Policy

& Practice, 2 (1), 9-22.

-

Mechtenberg, L. (2009). Cheap talk in the classroom: How biased grading at school explains gender differences in achievements, career choices and wages.The Review of Economic Studies, 76 (4), 1431-1459.

-

Mehrens, W. A. (1998). Consequences of Assessment: What is the Evidence. Education Policy Analysis Archives, 13(6), 1-30.

-

Merva, M. (2003). Grades as incentives: A quantitative assessment with implications

for study abroad programs. Journal of Studies in International Education, 7 (2), 149-56.

-

Meyer, B. J. F., Wijekumar, K., Middlemiss, W., Higley, K., Lei, P., Meier, C., & Spielvogel,

J. (2010). Web-based tutoring of the structure strategy with or without elaborated feedback or choice for fifth- and seventh-grade readers.Reading Research Quarterly, 45 (1), 62-92.

-

Mickwitz, L. (2011). Rätt betyg för vem? Betygsättning som institutionaliserad praktik (Doktorsavhandling,

Stockholms universitet).

-

Molden, D. C., & Dweck, C. S. (2006). Finding “meaning” in psychology: A

lay theories approach to self-regulation, social perception, and social

development. American Psychologist, 61(3), 192-203.

-

Morris, P. (2012). Pick’n’mix, select and project; policy borrowing and the quest for ‘world class’ schooling: an analysis of the 2010 schools White Paper. Journal of Education Policy, 27 (1), 89-107.

-

Muñoz, A. P., & Álvarez, M. E. (2010). Washback of an oral assessment system in the EFL classroom. Language testing, 27 (1), 33-49.

-

Myers, C. B., & Myers, S. M. (2007). Assessing assessment: The effects of two exam

formats on course achievement and evaluation. Innovative Higher Education, 31 (4), 227-236.

-

Natriello, G. (1987). The impact of evaluation processes on students. Educational

Psychologist, 22 (2), 155-175.

-

Neumann, M., Trautwein, U., & Nagy, G. (2011).

Do central examinations lead to Greater Grading comparability? A study of

frame-of-reference effects on the university entrance Qualification in Germany.

Studies in Educational Evaluation, 37(4), 206-217.

-

Nichols, S. L., Glass, G. V., & Berliner, D. C. (2006). High-stakes testing and student achievement: does accountability pressure increase student learning? Education Policy Analysis Archives,14 (1), 1-175.

-

Nichols, S. L., Glass, G. V., & Berliner, D. C. (2012). High-stakes testing and

student achievement: Updated analyses with NAEP data. Education Policy

Analysis Archives, 20(20).

-

Nieuwenhuis, J. (2010). Social justice in education revisited. Education Inquiry, 1 (4), 269-287.

-

Nowell, C., & Alston, R. M. (2007). I thought I got an A! Overconfidence across the economics curriculum. The Journal of Economic Education, 38 (2), 131-142.

-

Nyström, P. (2014). Rätt mätt på prov: om validering av bedömningar i skolan (Doktorsavhandling,

Umeå universitet, Pedagogiska institutionen).

-

Odenstad, C. (2010). Prov och bedömning i samhällskunskap: en analys av gymnasielärares

skriftliga prov (Licentiatavhandling, Karlstad universitet).

-

OECD 2005: Formative assessment: improving learning in secondary classrooms. Facsimile ed.

(2005). Paris: OECD.

-

OECD (2010). PISA 2009 Results: What Makes a School Successful?

Resources, Policies and Practices (Volume IV). Nedladdad 2014-12-28.

-

OECD (2012). Grade expectations: how marks and education policies shape students'

ambitions. Paris: Organisation for Economic Co-operation and Development

(OECD).

-

OECD (2013). PISA 2012 Results: What Makes a School Successful? Resources, Policies and Practices.

-

Oscarsson, M., & Apelgren B.-M. (2011). Mapping Language Teachers' Conceptions of

Student Assessment Procedures in Relation to Grading: A Two-Stage Empirical

Inquiry. System: An International Journal of Educational Technology and Applied

Linguistics,, 39 (1), 2-16.

-

Peterson, E., & Siadat, V. M. (2009). Combination of formative and summative assessment instruments in elementary algebra classes: A prescription for success. Journal of Applied Research in the Community College,16 (2), 92-102.

-

Pettersson, D., & Wester, A. (2010). Skolan i världen – internationella kunskapsmätningar. I C. Liberg, U. P. Lundgren & R. Säljö (red.), Lärande skolan

bildning. Natur & Kultur: Stockholm.

-

Pettersson, D. (2008). Internationell kunskapsbedömning som inslag i nationell styrning av skolan (Doktorsavhandling, Uppsala universitet).

-

Plank, S. B., & Falk Condliffe, B. (2013). Pressures of the Season: An Examination

of Classroom Quality and High-Stakes Accountability. American Educational Research Journal, 50 (5), 1152-1182.

-

Pope, N., Green, S. K, Johnson, R. L, & Mitchell, M. (2009). Examining teacher

ethical dilemmas in classroom assessment. Teaching and Teacher Education, 25 (5), 778-782.

-

Porter, A.C. (1993). School delivery standards.Educational Researcher, 22 (5), 24-30.

-

Promemoria 2014-08-20. U2014/4873/S En bättre skolstart för alla: bedömning och betyg för progression i

lärandet. Utbildningsdepartementet.

-

Pulfrey, C., Buchs, C., & Butera, F. (2011). Why grades engender performance-avoidance goals: The mediating role of autonomous motivation.Journal of Educational Psychology, 103 (3), 683-700.

-

Randall, J., & Engelhard, G (2010). Examining the grading practices of teachers Teaching

and Teacher Education, 26 (7), 1372-1380

-

Randall, J., & Engelhard, G. (2009). Differences Between Teachers' Grading Practices

in Elementary and Middle Schools. The Journal of educational research, 10 (3), 175-185.

-

Randall, J. & Engelhard, G. (2009). Examining teacher grades using Rasch measurement theory. Journal of Educational Measurement,, 46 (1), 1-18.

-

Ravitch, D. (2010). The death and life of the great American school system: how testing and choice are

undermining education. New York, NY: Basic Books.

-

Raymond, M. E., & Hanushek, E. A. (2003). High-stakes research. Education Next, 3 (3), 48-55.

-

Redelius, K., Fagrell B., & Larsson H. (2009). Symbolic capital in physical education

and health: to be, to do or to know? That is the gendered question. Sport, Education and Society, 14 (2), 245-260.

-

Redelius, K., Fagrell, B., & Larsson, H. (2009). Symbolic Capital in Physical Education and Health: To Be, to Do or to

Know? That Is the Gendered Question. Sport, Education and Society, 14 (2), 245-260.

-

Regeringens proposition 2008/09:66. En ny betygsskala. Stockholm: Utbildningsdepartementet. Regeringens proposition 2008/09:87. Tydligare mål och kunskapskrav – nya

läroplaner för skolan. Stockholm: Utbildningsdepartementet.

-

Resh, N. (2009). Justice in grades allocation: teachers’ perspective. Social Psychology of Education, 12 (3), 315-325.

-

Riksrevisionen (2004). Betyg med lika värde? En granskning av statens insatser. RiR

2004:23. Stockholm: Riksrevisionen.

-

Riksrevisionen (2011). Lika betyg, lika kunskap? En uppföljning av statens styrning mot en

likvärdig betygssättning i grundskolan. RiR 2011:23. Stockholm:

Riksrevisionen.

-

Rinne I. (2015). Pedagogisk takt i betygssamtal. En fenomenologisk hermeneutisk studie av gymnasielärares

och elevers förståelse av betyg (Doktorsavhandling, Göteborgs universitet, Institutionen

för didaktik och pedagogisk profession).

-

Risley, J. M. (2007). Reworking exams to teach chemistry content and reinforce student

learning. Journal of Chemical Education, 84(9), 1445-1447.

-

Ross, S. J. (2005). The impact of assessment method on foreign language proficiency

growth. Applied Linguistics, 26(3), 317-342.

-

Russel, J. A., & Austin, J. R. (2010). Assessment Practices of Secondary Music

Teachers. Journal of Research in Music Education, 58 (1), 37-54.

-

Rustique-Forrester, E. (2005). Accountability and the pressures to exclude: A cautionary tale from

England. Education Policy Analysis Archives, 13 (26).

-

Räihä, H. (2008). Lärares dilemman. Diss. Örebro

universitet.

-

Sawyer, R. (2013). Beyond Correlations: Usefulness of High School GPA and Test Scores

in Making College Admissions Decisions. Applied Measurement in Education, 26 (2),

89-112.

-

Schneeweis, N. (2011). Educational institutions and the integration of migrants. Journal of Population Economics, 24 (4), 1281-1308.

-

Scott, S., Webber, C. F., Lupart, J. L., Aitken, N., & Scott, D. E. (2014). Fair

and equitable assessment practices for all students. Assessment in Education: Principles, Policy & Practice, 21 (1), 52-70.

-

Seger, I. (2014). Betygsättningsprocess i ämnet idrott och hälsa: en studie om betygsättningsdilemman på högstadiet(Licentiatavhandling, Örebro universitet).

-

Selghed, B. (2007). Ännu icke godkänt. Lärares sätt att erfara betygssystemet och dess

tillämpning i yrkesutövningen (Doktorsavhandling, Malmö Högskola).

-

Senk, S. L., Beckmann, C. E., & Thompson, D. R. (1997). Assessment

and grading in high school mathematics classrooms. Journal for research in Mathematics Education, 28 (2), 187-215.

-

Shirvani, H. (2009). Examining an assessment strategy on high school mathematics

achievement: Daily quizzes vs. weekly tests. American Secondary Education, 38 (1), 34-45.

-

Shute, V. J. (2007). Focus on formative feedback.

Princeton, NJ: ETS.

-

Sikes, P., & Vincent, C. (1998). Social justice and education policy: an

introduction. Journal of Education Policy, 13 (4), 463-467.

-

Silva, M., Munk, D. D., & Bursuck, W. D. (2005). Grading Adaptations for Students

with Disabilities. Intervention in School & Clinic, 41 (2), 87-98.

-

Simon, M. Tierney, R. D., Forgette-Giroux, R. Charland, J., Noonan, B., & Duncan,

R. (2010). A Secondary School Teacher’s description of the process of

determining report card grades. McGill Journal of Education, 45 (3), 535-554.

-

Sjögren, A. (2010). Graded children – evidence of

longrun consequences of school grades from a nationwide reform. Working

paper 2010:7. Uppsala: IFAU – Institutet för arbetsmarknad och utbildningspolitisk utvärdering.

-

Skolinspektionen (2014). Uppenbar risk för felaktiga betyg. En kortrapport om likvärdighet och

kvalitet i skolors betygssättning. Skolverkets kvalitetsgranskning, rapport 2014:08.

-

Skolverket (2000). Skolverkets nationella kvalitetsgranskningar. Betygsättningen. Stockholm: Skolverket.

-

Skolverket (2002). Att bedöma eller döma: tio artiklar om bedömning och betygssättning. Stockholm:

Skolverket.

-

Skolverket (2007). Provbetyg-Slutbetyg-Likvärdig bedömning? En statistisk analys av sambandet mellan nationella prov och slutbetyg i grundskolan. Rapport 300. Stockholm: Skolverket.

-

Skolverket (2009). Likvärdig betygssättning i gymnasieskolan? En analys av sambandet mellan nationella prov

och kursbetyg. (Rapport 338). Stockholm: Skolverket.

-

SOU 1942:11. Betänkande med utredning och förslag angående betygssättningen i folkskolan.

Stockholm: Ecklesiastikdepartementet.

-

SOU 1977:9. Betygen i skolan. Betänkande av 1973 års betygsutredning. Stockholm:

Utbildningsdepartementet.

-

SOU 1992:86. Ett nytt betygssystem. Slutbetänkande av Betygsberedningen. Stockholm:

Utbildningsdepartementet.

-

Sprietsma M. (2012). Discrimination in grading: experimental evidence from primary school

teachers. American Economic Journal: Economic Policy, 4 (4), 146-168.

-

Stiggins, R., & Chappuis, J. (2006). What a difference a word makes: Assessment

“for” learning rather than assessment “of” learning helps students succeed. Journal of Staff Development, 27(1), 10-14.

-

Stobart, G. (2005a). Fairness in multicultural assessment systems. Assessment in Education: Principles, Policy & Practice, 12 (3), 275-287.

-

Stobart, G. (2005b). What does a grade mean? Assessment

in Education: Principles, Policy & Practice, 12(2), 101-103.

-

Stobart, G. (2008). Removing obstacles to fairness. Assessment in Education: Principles, Policy & Practice, 15(2), 121-122.

-

Stobart, G. (2009). Determining validity in national curriculum assessments. Educational Research, 51(2), 161-179.

-

Stobart, G., & Eggen, T. (2012). High-stakes testing – value, fairness and

consequences. Assessment in Education: Principles, Policy & Practice, 19 (1),

1-6.

-

Sun, Y., & Cheng, L. (2014). Teachers’ grading practices: meaning and values

assigned, Assessment in Education:

Principles, Policy & Practice, 21 (3), 326-343.

-

Suurtamm C., & Koch M. J. (2014). Navigating dilemmas in transforming

assessment. practices: experiences of mathematics teachers in Ontario, Canada.

Educational Assessment, Evaluation Accountability, 26 (3), 263-287.

-

Svennberg, L., Meckbach J., & Redelius, K. (2014). Exploring PE teachers' 'gut

feelings': An attempt to verbalise and discuss teachers' internalised grading

criteria. European Physical Education Review, 20 (2), 199-214.

-

Tan, C. (2011). Framing Educational Success: A Comparative Study of Shanghai and

Singapore. Education, Knowledge and Economy, 5 (3), 155-166.

-

Tekwe, C. D., Carter, R. L., Ma, C-X., Algina, J., Lucas, M. E., Roth, J., Ariet, M.,

Fisher, T., & Resnick, M. B. (2004). An Empirical Comparison of Statistical

Models for Value-Added Assessment of School Performance. Journal of Educational and Behavioral

Statistics, 29 (1), 11-35.

-

Tholin, J. (2006). Att kunna klara sig i ökänd natur: En studie av betyg och betygskriterier – historiska betingelser och implementering av ett nytt system (Doktorsavhandling, Högskolan i Borås,

Institutionen för pedagogik och didaktik).

-

Thompson, G. L., & Allen, T. G. (2012). Four effects of the high-stakes testing movement

on African American K-12 students. Journal of Negro Education, 81(3),

218-227.

-

Thorsen, C. (2014). Dimensions of Norm-Referenced Compulsory School Grades and their

Relative Importance for the Prediction of Upper Secondary School Grades. Scandinavian Journal of Educational Research, 58 (2), 127-146.

-

Thorsen, C., & Cliffordson, C. (2012). Teachers' Grade Assignment and the Predictive

Validity of Criterion-Referenced Grades. Educational

Research and Evaluation, 18 (2), 153-172.

-

Tierney, R D., Simon M., & Charland, J. (2011). Being Fair: Teachers’

Interpretations of Principles for Standards-Based Grading, The Educational Forum, 75 (3), 210-227.

-

Trotter, E. (2006). Student perceptions of continuous summative assessment (medel

relevans).Assessment & Evaluation in Higher Education, 31 (5),

505-521.

-

Tsagalidis, H. (2008). Därför fick jag bara Godkänt... : Bedömning i karaktärsämnen på

HR-programmet (Doktorsavhandling, Stockholms universitet, Pedagogiska

institutionen).

-

Tveit, S. (2014). Educational assessment in Norway, Assessment in Education: Principles, Policy & Practice, 21(2), 221-237.

-

Vaden-Goad, R. (2009). Leveraging summative assessment for formative purposes. College

Teaching, 57(3), 153-155.

-

van Ackeren, I., Block, R., Klein, E. D., & Kuhn, S. M. (2012). The impact of

statewide exit exams: A descriptive case study of three German states with

differing low stakes exam regimes. Education Policy Analysis Archives, 20(8).

-

van der Keij, K., Eggen, T. J. H. M., Timmers, C. F., & Veldkamp, B. P. (2012).

Effects of feedback in a computer-based assessment for learning. Computers

& Education, 58(1), 263-272.

-

van Ewijk, R. (2011). Same Work, Lower Grade? Student Ethnicity and Teachers'

Subjective Assessments Economics of Education Review, 30 (5),1045-1058.

-

Vlachos, J. (2010). Betygets värde – en analys av hur konkurrens påverkar betygssättningen

vid svenska skolor. Konkurrensverket

uppdragsforskningsrapport 2010:6.

-

Vosti, K. L., & Jacobs, C. D. (1999). Outcome measurement in postgraduate year one

of graduates from a medical school with a Pass/Fail grading system.Academic

Medicine, 74 (5), 547-49.

-

Wahlström, N. (2012). Den effektiva läraren. I T. Englund(red.), Föreställningar om den goda

läraren. Göteborg: Daidalos.

-

Waldow, F., Takayama, K., & Youl-Kwan, S.

(2014). Rethinking the pattern of external policy referencing: media discourses

over the ‘Asian Tigers’’ PISA success in Australia, Germany and South Korea. Comparative Education, 50 (3), 302-321.

-

Waldow, F. (2014). Conceptions of Justice in the Examination Systems of England,

Germany, and Sweden: A Look at Safeguards of Fair Procedure and Possibilities

of Appeal. Comparative Education Review, , 58 (2), 322-343.

-

Wang, A. H., Walters, A. M., & Thum, Y. M. (2013). Identifying

highly effective urban schools: comparing two measures of school success. International

Journal of Educational Management, 27 (5), 517-540.

-

Wang, J. (2001). TIMSS Primary and Middle School Data: Some Technical Concerns. Educational Researcher, 30 (6), 17-21.

-

Wedin, A-S. (2007). Lärares arbete och kunskapsbildning Utmaningar och inviter i den vardagliga praktiken

(Doktorsavhandling, Linköpings universitet, Institutionen för beteendevetenskap och lärande).

-

Welsh, M: E., D'Agostino, J. V., & Kaniskan, B. 2013. Grading

as a reform effort: Do standards based grades converge with test scores? Educational Measurement:

Issues and Practice, 32 (2), 26-36.

-

White, C. B., & Fantone, J. C. (2010). Pass-fail grading: Laying the foundation

for self-regulated learning. Advances in Health Sciences Education, 15 (4),

469-477.

-

Wikström, C. (2005). Grade stability in a criterion ‐ referenced grading system: the Swedish example. Assessment in Education: Principles, Policy & Practice, 12 (2), 125-144.

-

Wikström, C. (2005). Criterion-referenced measurement for educational evaluation and selection (Doktorsavhandling, Umeå universitet, Umeå universitet, Institutionen för beteendevetenskapliga

mätningar).

-

Wikström, C. (2009). National Curriculum Assessment in England – A Swedish Perspective. Educational Research, 51 (2), 255-258.

-

Wilamowsky, Y., Dickman, B. H., & Epstein, S. (2008). The effect of Plus/Minus grading

on the GPA. Journal of College Teaching & Learning, 5(9), 1-8.

-

Williams, J. E., Garza, L., Hodge, A. A., & Breaux, A. (1999). The color of teachers, the color of students: The multicultural classroom experience. Teaching sociology, 27 (3),

-

Willingham, W. W., Pollack J. M., & Lewis, C. (2002). Grades and Test Scores:

Accounting for Observed Differences. Journal of Educational Measurement, 39 (1), 1-37.

-

Winters, M. A., & Cowen, J. M. (2012). Grading New York: Accountability and student

proficiency in America's largest school district. Educational Evaluation and

Policy Analysis, 34 (3), 313-327.

- Wyatt ‐ Smith, C., Klenowski, V., & Gunn, S. (2010). The centrality of teachers’ judgment practice in assessment: a study of standards in moderation. Assessment in Education: Principles, Policy & Practice, 17 (1), 59-75.

-

Wyse, D., & Torrance, H. (2009). The development and consequences of national curriculum assessment for primary education in England. Educational Research, 51 (2), 213-228.

-

Wößmann, L. (2005). The effect heterogeneity of central examinations:

evidence from TIMSS, TIMSS ‐ Repeat and PISA. Education

Economics, 13 (2), 143-169.

-

Yin, Y., Shavelson, R. J., Ayala, C. C., Ruiz-Primo, M., Brandon, P. R., Furtak, E.

M., Tomita, M.K., & Young, D.B. (2008). On the impact of formative

assessment on student motivation, achievement, and conceptual change.

Applied Measurement in Education, 21 (4), 335-359.

- Zoeckler, L. G. (2007). Moral aspects of grading: a study of high school English teachers’ perceptions. American secondary education, 35 (2), 83-102.

No comments:

Post a Comment